想像一下,在《英雄聯盟》的關鍵團戰中,10名玩家同時施放技能,每個閃現、每個技能都必須在毫秒內精準同步。一個 50 毫秒的延遲差異,就足以讓職業選手的神級操作變成笑話。

而當《楓之谷》在 2003 年進軍全球市場時,從韓國的數萬玩家突然暴增到全球千萬用戶,他們經歷了無數次的伺服器崩潰、回檔事件,甚至出現了著名的「楓谷大斷線」事件。

這就是線上遊戲系統設計的殘酷現實:你必須為無法預測的成功做好準備,同時還要對抗外掛程式、處理網路延遲,並維持流暢的遊戲體驗。

今天,我們將深入探討線上遊戲系統的架構設計,從獨立遊戲的簡單多人連線,到 AAA 級遊戲的全球規模部署。你將學會如何選擇適合的網路架構、實現高效的狀態同步機制、建立反作弊系統,以及規劃從百人到百萬人的擴展策略。

場景定義與需求分析

業務場景描述

現代線上遊戲涵蓋了從休閒派對遊戲到競技電競的廣泛類型。一個成功的線上遊戲系統必須同時滿足多種需求:即時戰鬥遊戲需要極低延遲的操作反饋、大型多人遊戲需要處理數千人同時互動、競技遊戲需要絕對的公平性與反作弊保護。

系統的核心價值在於創造「共同體驗」——讓分散在世界各地的玩家能夠在同一個虛擬空間中即時互動,無論是合作闖關還是競技對戰,都能感受到流暢且公平的遊戲體驗。

核心需求分析

功能性需求

-

即時狀態同步:玩家位置、動作、技能施放在 50-100ms 內同步到所有相關客戶端

-

配對系統:根據玩家技能等級、延遲、偏好進行智能匹配

-

會話管理:支援創建房間、加入遊戲、斷線重連、觀戰模式

-

社交功能:遊戲內語音聊天、文字訊息、好友系統、戰隊管理

-

進度持久化:玩家等級、成就、物品、戰績的可靠儲存

-

反作弊保護:即時偵測與封禁作弊行為

-

跨平台支援:PC、主機、手機玩家可在同一場遊戲中對戰

非功能性需求

- 效能要求:P50 延遲 < 50ms,P99 延遲 < 150ms(區域內)

- 可用性要求:99.9% SLA,計劃維護時間 < 4小時/月

- 擴展性要求:能在 15 分鐘內自動擴展 10 倍容量

- 安全性要求:端到端加密、DDoS 防護、數據隱私保護

- 成本限制:每千名同時在線玩家的基礎設施成本 < $100/月

核心架構決策

識別關鍵問題

-

技術挑戰 1:網路架構選型

不同的網路架構模型直接決定了遊戲的延遲表現、擴展能力和反作弊強度。選擇錯誤的架構可能導致後期無法修正的設計缺陷。

-

技術挑戰 2:狀態同步機制

如何在網路延遲和丟包的情況下,讓所有玩家看到一致且流暢的遊戲世界?這涉及預測、插值、回滾等複雜的同步技術。

-

技術挑戰 3:規模化與成本控制

從小型獨立遊戲成長為全球熱門遊戲,基礎設施成本可能從每月數百美元暴增到數百萬美元。

架構方案比較

| 維度 |

P2P 點對點 |

客戶端-伺服器 |

專用伺服器叢集 |

| 核心特點 |

玩家直接連接 |

單一權威伺服器 |

分散式處理 |

| 優勢 |

零伺服器成本、最低延遲 |

反作弊能力強、狀態一致 |

全球覆蓋、高可用性 |

| 劣勢 |

作弊風險高、NAT 穿透複雜 |

伺服器成本、單點故障 |

架構複雜、成本高昂 |

| 適用場景 |

小型合作遊戲 |

中小型競技遊戲 |

AAA級全球服務 |

| 複雜度 |

低 |

中等 |

高 |

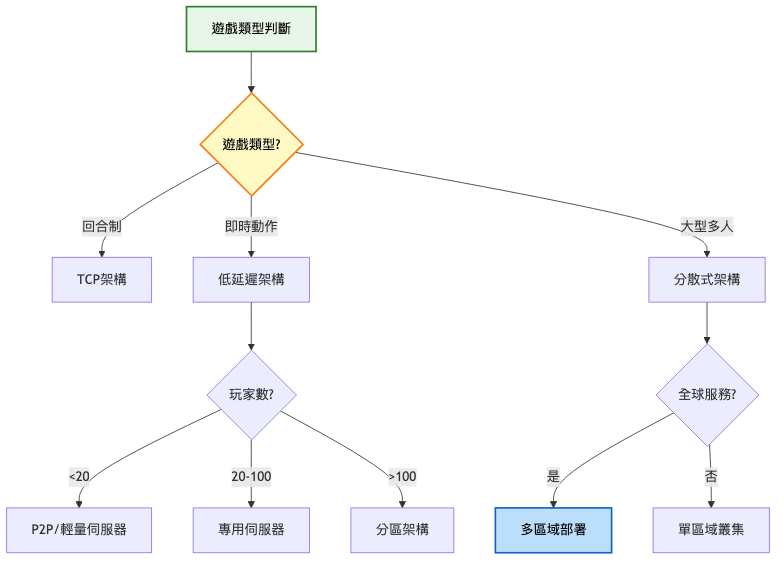

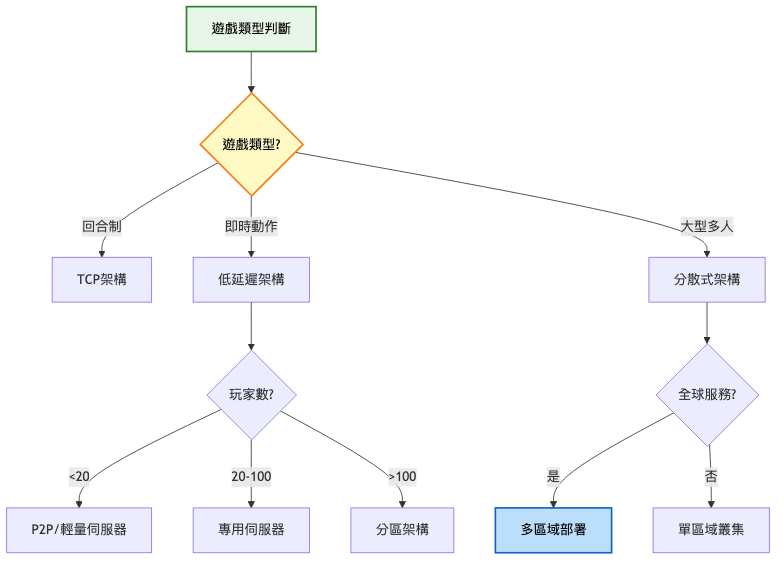

決策思考框架

系統演進路徑

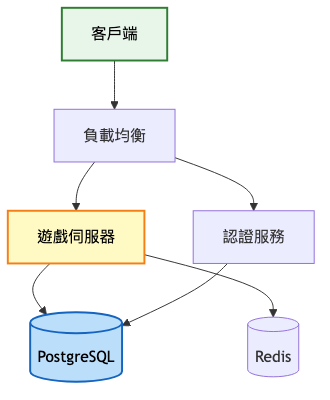

第一階段:MVP(< 1000 用戶)

架構重點:

- 使用遊戲引擎內建網路功能快速開發

- 單一區域部署降低複雜度

- 簡單的配對邏輯

- 基礎反作弊檢測

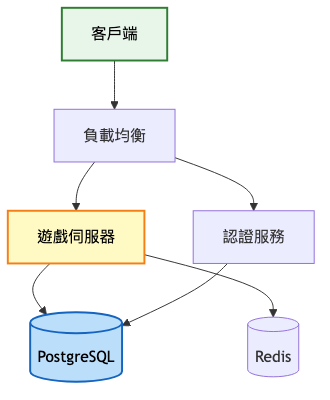

系統架構圖:

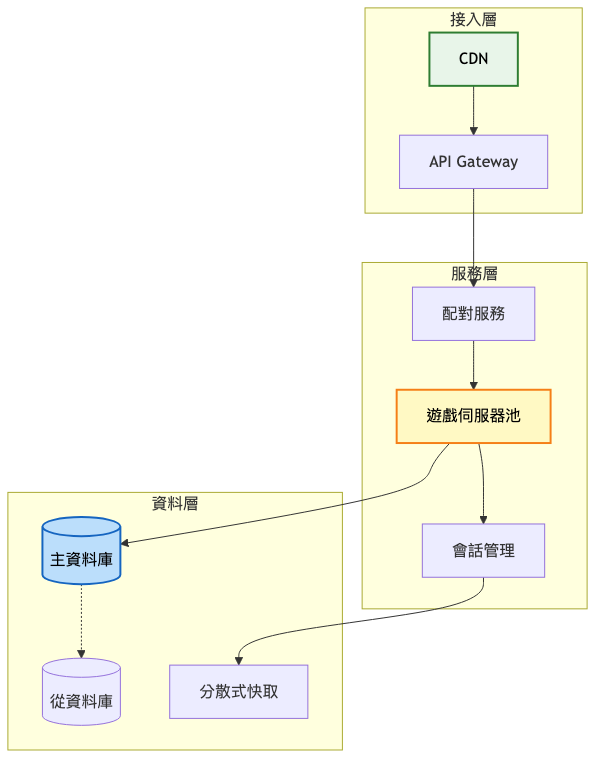

第二階段:成長期(1000-10萬 用戶)

架構重點:

- 引入專用遊戲伺服器池

- 實施技能配對系統(SBMM)

- 添加 CDN 加速資源下載

- 基礎監控與分析系統

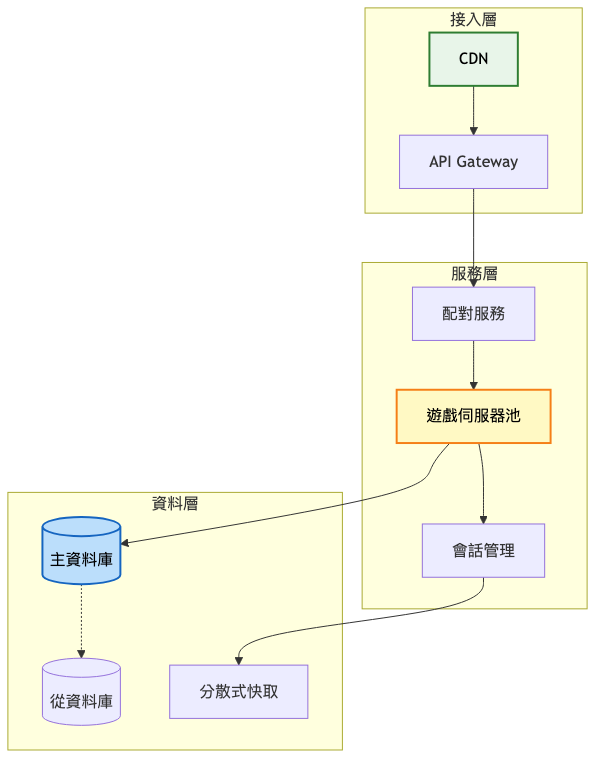

系統架構圖:

關鍵架構變更:

-

自動擴展遊戲伺服器

- 使用 Kubernetes 管理容器化伺服器

- 根據玩家數量自動擴縮容

- 預期效果:響應時間降低 40%

-

分散式會話管理

- Redis Cluster 儲存會話狀態

- 支援跨伺服器的玩家遷移

- 實現無縫斷線重連

-

智能配對演算法

- 實施 TrueSkill 評分系統

- 考慮延遲、技能、隊伍平衡

- 平均配對時間:60秒→20秒

預期效能提升對比表:

| 指標 |

第一階段 |

第二階段 |

改善幅度 |

| 平均延遲 |

100ms |

60ms |

-40% |

| 配對時間 |

60s |

20s |

-67% |

| 同時在線 |

1000 |

100000 |

100x |

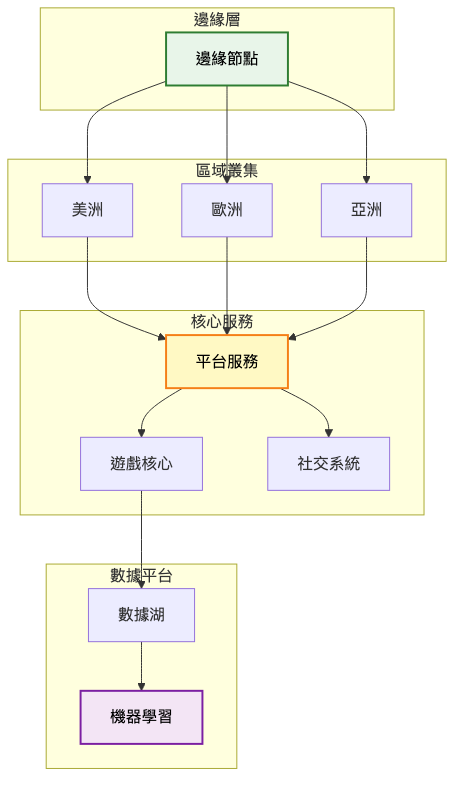

第三階段:規模化(10萬+ 用戶)

架構重點:

- 多區域部署實現全球覆蓋

- 微服務架構提升可維護性

- AI 驅動的反作弊系統

- 邊緣計算降低延遲

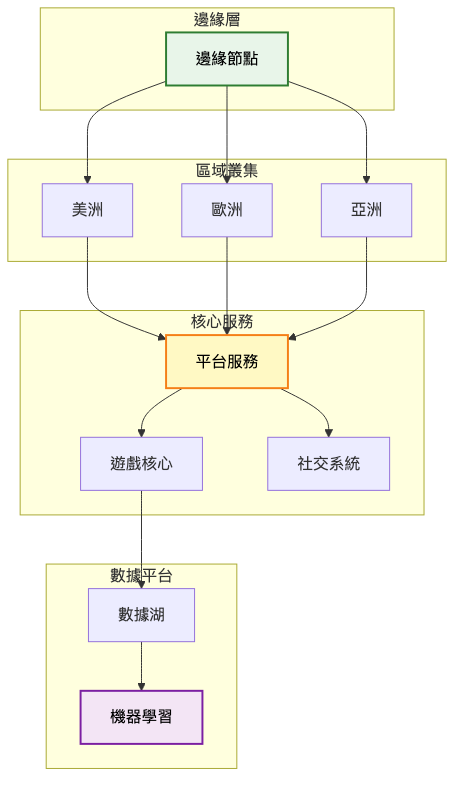

總覽圖:服務分組關係

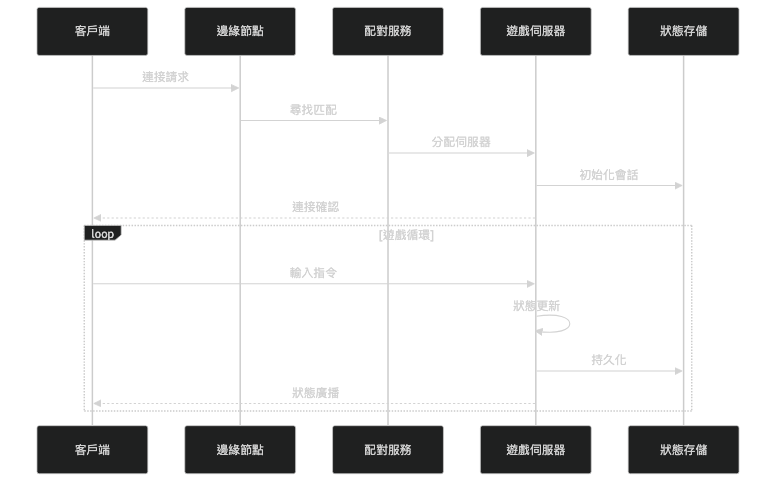

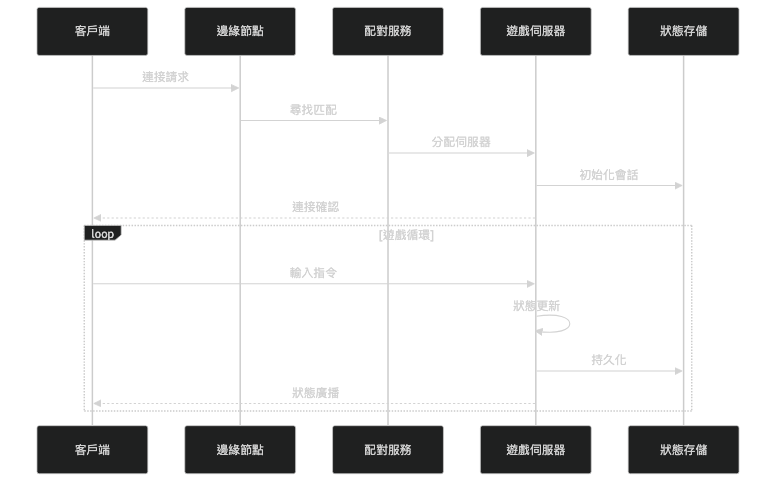

詳細圖1:核心業務流程

關鍵變更:

-

全球智能路由

- Anycast IP 自動選擇最近節點

- 動態調整路由避開網路擁塞

- P50 延遲降至 30ms 以下

-

機器學習反作弊

- 行為模式異常檢測

- 硬體指紋追蹤

- 檢測準確率達 99.9%

-

成本優化策略

- Spot 實例降低 90% 運算成本

- 智能預載減少頻寬使用

- 每千人成本降至 $80/月

階段演進總覽表:

| 架構特性 |

MVP階段 |

成長期 |

規模化 |

| 架構模式 |

單體應用 |

服務化 |

微服務 |

| 資料庫 |

單一資料庫 |

主從分離 |

分片集群 |

| 快取策略 |

簡單快取 |

多層快取 |

分散式快取 |

| 部署方式 |

單機/少量機器 |

集群部署 |

容器化/K8s |

| 用戶規模 |

< 1千 |

1千-10萬 |

10萬+ |

演進決策指南表:

| 觸發條件 |

採取行動 |

預期效果 |

| 同時在線超過 1000 |

啟用自動擴展 |

降低 40% 延遲 |

| 配對等待 > 60秒 |

部署更多區域 |

等待時間減半 |

| 作弊率 > 1% |

升級反作弊系統 |

作弊率降至 0.1% |

| 成本 > $100/千人 |

優化資源配置 |

成本降低 50% |

技術選型深度分析

關鍵技術組件比較

網路協定選擇

| 技術選項 |

優勢 |

劣勢 |

適用場景 |

| TCP |

可靠傳輸、順序保證 |

隊頭阻塞、延遲較高 |

回合制、卡牌遊戲 |

| UDP |

低延遲、無阻塞 |

需自行處理可靠性 |

FPS、格鬥遊戲 |

| WebRTC |

瀏覽器原生、P2P 支援 |

配置複雜、穿透率低 |

網頁遊戲、輕量對戰 |

| QUIC |

結合TCP/UDP優點 |

相對較新、支援有限 |

下一代遊戲架構 |

狀態同步策略

| 方案 |

優勢 |

劣勢 |

適用場景 |

| 鎖步同步 |

頻寬最小、完全一致 |

延遲高、要求確定性 |

RTS、回合制 |

| 狀態同步 |

簡單可靠、容錯性好 |

頻寬較大、可能卡頓 |

MOBA、MMO |

| 預測回滾 |

零延遲體驗、精確 |

實作複雜、CPU 密集 |

格鬥、FPS |

反作弊方案

| 技術選項 |

優勢 |

劣勢 |

適用場景 |

| BattlEye |

檢測率 99.9%、核心層保護 |

價格昂貴、可能影響效能 |

競技遊戲 |

| EasyAntiCheat |

硬體封禁、引擎整合好 |

誤判可能、繞過方法多 |

大眾遊戲 |

| 伺服器驗證 |

無法繞過、零客戶端成本 |

開發成本高、延遲增加 |

所有遊戲基礎 |

| AI 行為分析 |

檢測未知作弊、自動學習 |

需要大量數據、可能誤判 |

輔助檢測 |

技術演進策略

-

初期技術建立:使用成熟的遊戲引擎網路方案(Mirror、Photon),專注遊戲玩法開發

-

成長期靈活調整:根據實際瓶頸優化,可能是網路協議、狀態同步或伺服器架構

-

成熟期精細優化:自定義協議、專屬網路、邊緣節點等深度優化

實戰經驗與教訓

常見架構陷阱

-

過早優化網路協議

- 錯誤:一開始就實作複雜的自定義 UDP 協議

- 正確:先用成熟方案,有需要再優化

- 原因:過早優化會延緩上線時間,且可能優化錯方向

-

忽視作弊預防

- 錯誤:把反作弊當作後期功能

- 正確:從第一天就設計權威伺服器架構

- 原因:客戶端信任的架構後期極難修正

-

狀態同步過度依賴客戶端

- 錯誤:讓客戶端決定遊戲狀態

- 正確:伺服器為唯一真實來源

- 原因:客戶端可被修改,信任客戶端等於為作弊開門

業界案例分析

案例一:《英雄聯盟》的網路優化之路 Riot Games 技術部落格

發展歷程

-

初期(2009-2011)

- 架構特點:單一資料中心、簡單客戶端-伺服器模型

- 技術:Adobe Air 客戶端、自定義 C++ 遊戲伺服器

- 規模:數萬同時在線玩家

-

成長期(2012-2016)

- 主要改進:建立全球資料中心、優化網路協議

- 遇到的挑戰:ISP 路由問題導致高延遲、DDoS 攻擊頻繁

- 解決方案:建立 Riot Direct 專屬網路骨幹

-

成熟期(2017-現在)

- 當前架構特點:全球專屬網路、邊緣 PoP 節點覆蓋

- 技術創新:預測性路由、自適應 QoS

- 成果:平均延遲降低 33%、封包遺失率降低 60%

關鍵學習點

- 學習點 1:網路品質比伺服器性能更影響玩家體驗

- 學習點 2:與 ISP 建立直接合作關係可顯著改善延遲

- 學習點 3:投資專屬網路基礎設施是長期競爭優勢

案例二:《Among Us》的緊急擴展經驗 Unity 案例研究

發展歷程

-

初期(2018-2020.8)

- 架構特點:簡單的 P2P 配對系統、基礎伺服器

- 技術:Unity 引擎、自託管伺服器

- 規模:平均 30-50 人同時在線

-

爆紅期(2020.9-2020.12)

- 主要改進:緊急遷移到 Unity Gaming Services

- 遇到的挑戰:伺服器每天崩潰、配對系統癱瘓

- 解決方案:雲端自動擴展、CDN 加速

-

穩定期(2021-現在)

- 當前架構特點:專用伺服器取代 P2P、強化反作弊

- 成果:支援 1500 萬月活躍用戶

關鍵學習點

- 學習點 1:保持架構彈性,隨時準備應對爆發性增長

- 學習點 2:雲端服務可在危機時提供快速擴展能力

- 學習點 3:早期的技術債會在規模化時成倍放大

關鍵設計模式

設計模式應用

客戶端預測模式

- 使用場景:降低操作延遲,提供即時反饋

- 實施方式:客戶端立即執行動作,等待伺服器確認後校正

- 注意事項:需要處理預測錯誤的回滾邏輯

命令模式

- 使用場景:記錄和重放玩家操作,支援觀戰和錄影

- 實施方式:將所有操作封裝為命令物件

- 注意事項:命令需要包含時間戳和序列號

狀態機模式

- 使用場景:管理遊戲會話的生命週期

- 實施方式:定義明確的狀態轉換規則

- 注意事項:處理異常狀態轉換和超時

最佳實踐

-

權威伺服器原則:所有遊戲邏輯判定必須在伺服器端執行

-

樂觀更新策略:先更新客戶端,後續校正,提供流暢體驗

-

差異化同步頻率:重要物件高頻更新,次要物件低頻更新

-

智能插值算法:使用二次插值而非線性,提供更自然的移動

監控與維護策略

關鍵指標體系

技術指標:

- 伺服器 Tick Rate(目標:30-60 Hz)

- 網路 RTT 分佈(P50 < 50ms, P99 < 150ms)

- 封包遺失率(目標 < 1%)

- 伺服器 CPU 使用率(警戒線 80%)

- 記憶體使用率(警戒線 85%)

業務指標:

- 配對成功率(目標 > 95%)

- 平均配對時間(目標 < 30秒)

- 遊戲完成率(目標 > 80%)

- 作弊檢測率(目標 > 99%)

- 玩家留存率(次日 > 40%、七日 > 20%)

維護最佳實踐

-

灰度發布策略

- 新版本先發布到 5% 玩家

- 監控關鍵指標 24 小時

- 逐步擴大到 100%

-

自動化回滾機制

- 錯誤率超過閾值自動回滾

- 保留最近 3 個穩定版本

- 回滾時間 < 5 分鐘

-

容災演練

- 每月進行故障演練

- 測試自動故障轉移

- 驗證數據備份恢復

總結

核心要點回顧

- 線上遊戲系統設計需要平衡延遲、一致性、擴展性與成本

- 網路架構選擇決定了系統的基因,必須根據遊戲類型謹慎選擇

- 狀態同步機制直接影響玩家體驗,需要在準確性和流暢度間權衡

- 反作弊系統必須從第一天開始設計,後期補救成本極高

- 監控和數據分析是持續優化的基礎,沒有數據就沒有優化方向

設計原則提煉

-

權威伺服器原則:永遠不要信任客戶端

-

漸進式複雜度:從簡單可行的方案開始,根據需求演進

-

延遲優先於吞吐:100ms 的延遲比 10Mbps 的頻寬更致命

-

監控驅動優化:建立完整的監控體系是優化的前提

-

為失敗設計:優雅的降級策略比完美的系統更實際

進階延伸關鍵字

針對今日探討的線上遊戲系統設計,建議可從以下關鍵字或概念深化研究與實踐,以擴展技術視野與解決方案能力:

-

Netcode 與 Rollback:透過進一步學習 GGPO、Rollback Netcode 的實作原理,能加強對即時同步問題的理解與應用。

-

Distributed Game Simulation:這部分涉及分散式物理模擬、大規模 AI 計算等關鍵技術,適合深入掌握以提升系統效能。

-

Edge Computing for Gaming:探索邊緣計算本質及其最佳實踐,幫助設計更低延遲的遊戲架構。

-

Game Security & Anti-Cheat:關注核心層反作弊、行為分析等領域最新發展,保持技術與時俱進。

可根據自身興趣,針對上述關鍵字搜尋 GDC Vault、Riot Games 技術部落格等資源,逐步累積專業知識和實踐經驗。

下期預告

明天我們將進入「金融交易系統」的設計領域。當每一筆交易都涉及真金白銀,當毫秒級的延遲可能造成數百萬的損失,系統設計將面臨完全不同層次的挑戰。我們會探討如何在保證絕對一致性的同時達到高頻交易的效能要求。

參考資源